Het klinkt misschien als sciencefiction, maar deepfake-stemmen zijn in 2025 moeilijker te onderscheiden dan ooit — zelfs voor nuchtere Nederlanders.

Uit nieuw onderzoek van University College London blijkt dat mensen ruim een kwart van de deepfake-gesprekken gemaakt met kunstmatige intelligentie niet herkennen als nep. Zélfs na een korte training zijn onze oren snel te misleiden.

Wat zijn deepfakes eigenlijk?

Deepfakes gaan verder dan een gephotoshopte selfie. Met deze technologie wordt in video’s of audio-opnames het gezicht, de stem of zelfs de mimiek van een persoon nagebootst. Het Massachusetts Institute of Technology omschrijft het als: “iemand in een beeld of video verwisselen met het gezicht of de stem van een ander”.

Denk aan een politicus, BN’er of zelfs je collega uit Delft die ineens iets zegt — of lijkt te zeggen — puur gecreëerd door een computer. Handig voor grappige filmpjes, maar ook een gevaar bij oplichting.

Het experiment: Kan jij een deepfake-stem herkennen?

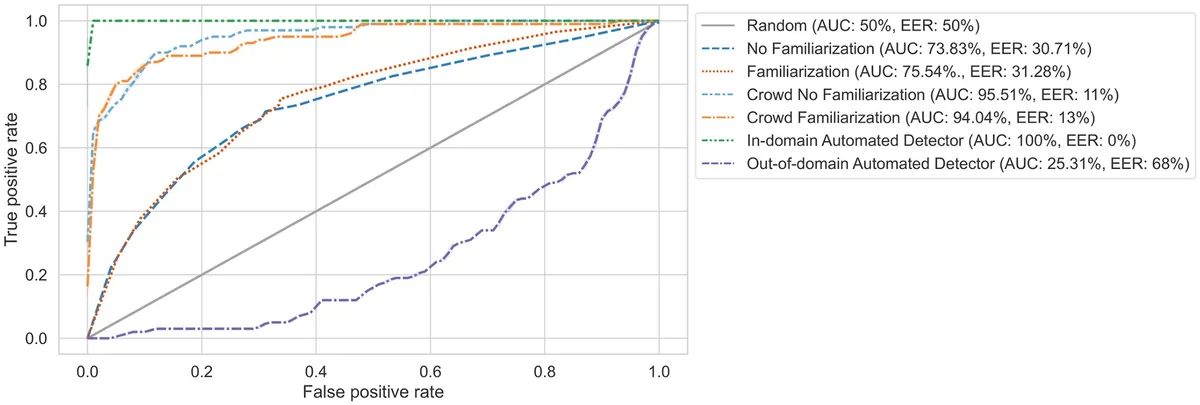

De UCL-wetenschappers gebruikten twee openbare datasets om 50 deepfake-stemmen te maken, zowel in het Engels als in het Mandarijn. Aan 529 proefpersonen (nee, geen AI’s) werd gevraagd: “Welke stem is echt, welke is nep?”

Het resultaat? Slechts 73% van de nepstemmen werd correct als nep herkend. Dat cijfer verbeterde nauwelijks na een korte uitleg over hoe je zulke stemmen zou moeten ontmaskeren.

Wat opvalt: Oude technieken al bijna niet te onderscheiden

Volgens promovenda en co-auteur Kimberly Mai zijn de gebruikte algoritmes in het onderzoek “verouderd” naar huidige maatstaven. Met de nieuwste software, die zelfs de zachte Brabantse ‘g’ of de Friese tongval kan nabootsen met een spraakfragment van drie seconden, is het verschil waarschijnlijk nog moeilijker te horen.

Dus: als u zich afvraagt of de stem op die audio-app van je ‘baas’ echt is — misschien toch even dubbelchecken.

Verschillen tussen Engels en Mandarijn? Nauwelijks

Engelstalige en Mandarijnsprekende deelnemers presteerden ongeveer gelijk. Opvallend: Nederlanders letten bij stemherkenning vaak op adempauzes (“dat hoorde je gewoon niet kloppen!”), terwijl Mandarijnsprekers vooral het ritme belangrijk vinden.

Wat nu? Van slimme detectie tot bewustwording

De onderzoekers waarschuwen: deepfake-technologie wordt steeds toegankelijker — en sterker. Het Amsterdamse cybersecuritybedrijf Fox-IT adviseert nu al bedrijven om medewerkers te trainen in het herkennen van verdachte audio, want de gevaren raken steeds meer mensen: van valse telefoontjes tot nep-volwassenenstemmen om wachtwoorden los te peuteren.

Professor Lewis Griffin zegt het zo: “Met generatieve AI die steeds slimmer wordt en vrij beschikbaar is, moet je als overheid en organisatie voorbereid zijn op misbruik — maar de techniek heeft óók mooie kanten. Stemassistenten, inclusieve media, innovatieve healthcare-toepassingen in bijvoorbeeld het UMC Utrecht…”

Hoe bescherm je jezelf tegen deepfake-oplichting?

- Twijfel je aan een stem—bel altijd even terug op een bekend nummer.

- Gebruik ‘safe words’ binnen het gezin of op het werk bij gevoelige vragen.

- Houd audio van persoonlijke of financiële kwesties altijd privé.

Blik op de toekomst: Nepnieuws rond verkiezingen en meer scams

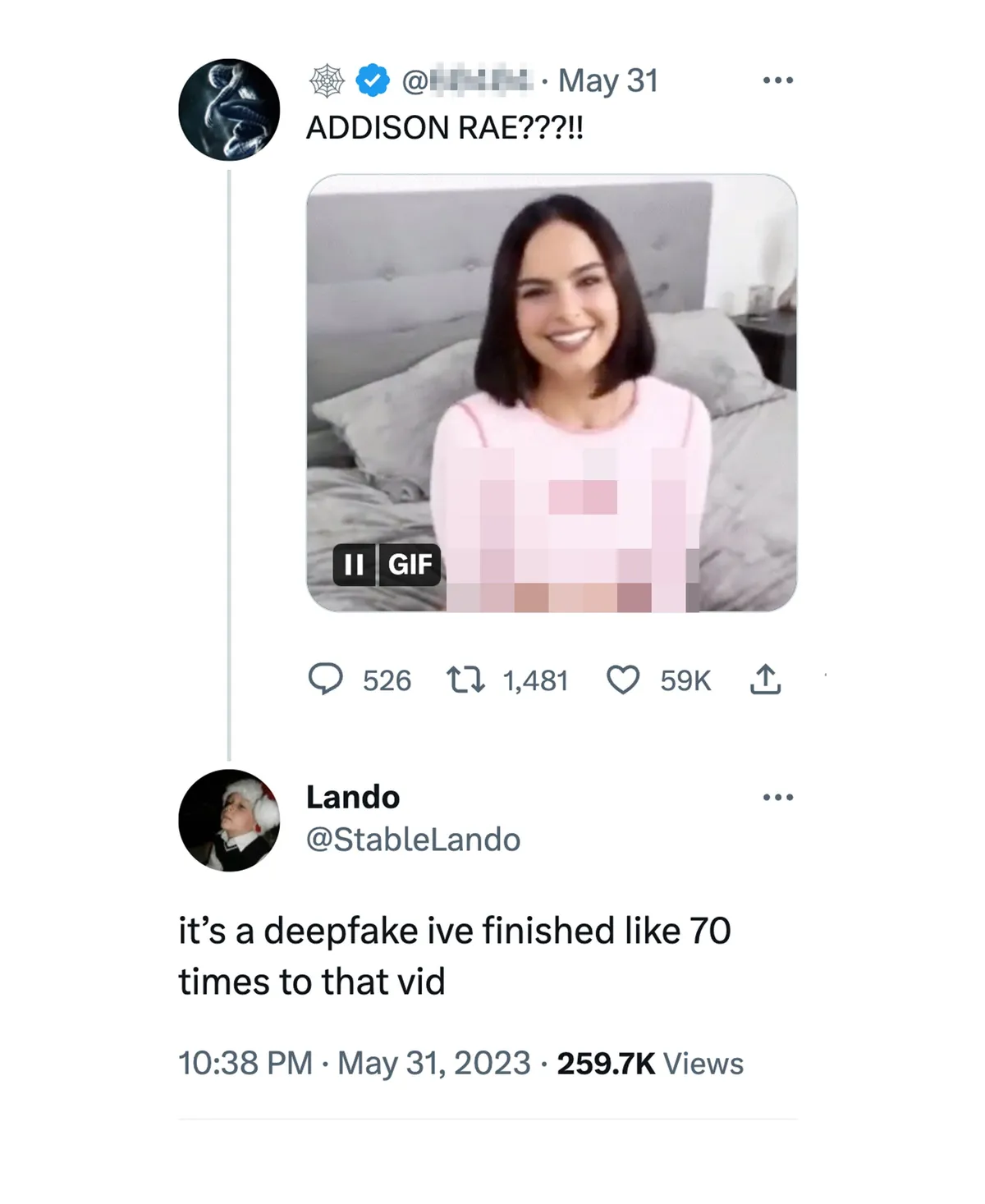

Experts verwachten dat deepfakes bij de komende verkiezingen, maar ook online in apps als WhatsApp en als audio-berichten in Zoom, nog meer schade kunnen aanrichten. Er circuleren al nepoproepen van ‘bankmedewerkers’ en deepfake-porno van bekende Nederlanders.

De boodschap? Slim zijn, kritisch luisteren en soms gewoon ouderwets face-to-face afspreken — digitaal vertrouwen heeft zijn grenzen.